telepolis, 17.04.2013

Signal? Rauschen?

Jörg Auf dem Hövel

Die junge Disziplin der Neurowissenschaft kämpft mit statistischen Unzulänglichkeiten

Der Meldungsstrom aus den Neurowissenschaften reißt nicht ab. Bunte Bilder zeigen Gehirnaktivitäten, Träume scheinen greif-, Gedanken dekodier-, Gedächtnisbildung beeinflussbar. Die USA spendieren 100 Millionen Dollar, um allen Neuronen beim werkeln zuzusehen (BRAIN Initiative), die EU möchte das gesamte neuronale Spiel in Silizium gießen (Human Brain Project). Nun mehrt sich Kritik, Statistiker weisen auf die Unzulänglichkeiten vieler Studienergebnisse hin. Glaubt man diesen Stimmen, steht nicht nur die Neurowissenschaft, sondern das System der medizinisch-klinischen Studien auf dem Prüfstand. Optimierungsvorschläge werden diskutiert.

Im renommierten Fachblatt „Nature Reviews Neuroscience“ ist jetzt ein Beitrag erschienen, der die statistische Aussagekraft einer Reihe von neurowissenschaftlicher Studien analysiert. Die Autoren um den Psychologen Marcus R. Munafò nahmen sich dafür alle 49 in 2011 veröffentlichten Meta-Analysen zur Brust. Diese beinhalteten wiederum 730 Studien. Das Ergebnis war in dieser Form selbst für die Autoren überraschend: Die durchschnittliche (Median) Teststärke lag aufgrund der kleinen Studiengröße bei nur 21%. Gemeinhin wird eine Teststärke von rund 80% als adäquat angesehen. Eine solche findet in vier von fünf Fällen einen Effekt – wenn denn einer existiert. Bei einer so geringen Aussagekraft wie in den untersuchten Studien steigt nicht nur die Chance, dass ein Effekt gefunden wird wo keiner ist, sondern auch die Wahrscheinlichkeit, dass dieser überbewertet wird.

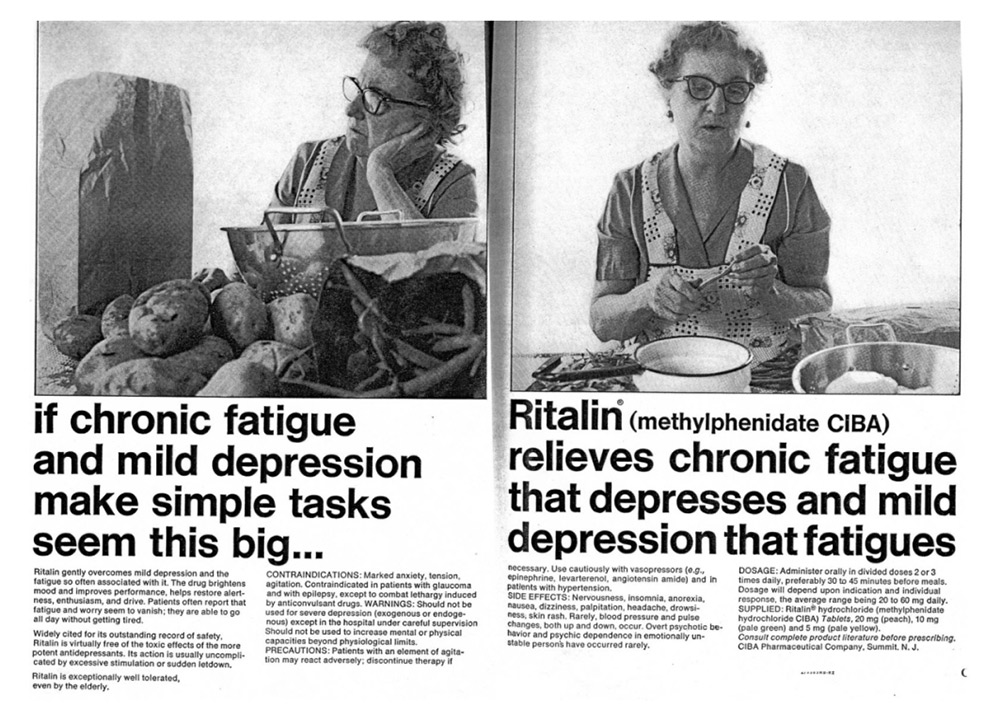

Einschränkend muss erwähnt werden, dass die meisten der vom Autorenteam untersuchten Meta-Analysen den Effekt von Psychopharmaka und genetischen Dispositionen auf das mentale Befinden zum Thema haben und demnach wahrlich nicht das gesamte Feld der Neurowissenschaften abdecken. Allerdings wurde auch für die beliebten Studien zur Visualisierung von Gehirnaktivität schon gezeigt, dass sie zum einen dazu tendieren, negative Studienergebnisse nicht zu publizieren, und zum anderen ebenfalls eine schwache Teststärke aufweisen.

Schlechtes Studiendesign sowie die Überinterpretation von Ergebnissen in Fachblättern und Populärmedien sind nicht nur für die Neurowissenschaft virulent. Genetik, Medizin und Psychologie sind andere Disziplinen, die darunter leiden, dass viele Experimente nicht wiederholt werden. Dabei gibt es gute Gründe dafür, denn immer wieder tauchen Studien auf, die Kausalzusammenhänge zwischen Phänomenen aufzeigen, die später in größeren Studien nicht bestätigt werden können. Paradebeispiel ist hier die Genforschung, die gerade am Anfang ihrer Forschungsära mittels kleiner Studien menschliches Verhalten oder eine Krankheit mit einer spezifischen, genetischen Variante erklären wollte.

Im Grunde funktioniert so Forschung: Hypothesen werden aufgestellt und bestätigt oder verworfen. Ein anderer Wissenschaftler wiederholt das Experiment. Langsam nähert man sich der Wahrheit, es sei denn jemand zeigt auf, dass schon die vorbedingten Grundannahmen falsch sind. In der Realität wird allerdings schon die Widerlegung einer Hypothese ungern veröffentlicht, denn lieber sieht man seine Arbeit bestätigt.

Was tun? Eine niedrige Aussagekraft ist gerade bei kleineren Studien nahezu unvermeidlich. Der Forderung nach größeren Studiengruppen liegt nahe, ist aber damit auch eine nach mehr Geld und impliziert damit wiederum, um es weit zu treiben, die Verfestigung eh schon etablierter Forschungsstrukturen in großen Institutionen. Die Erforschung von nicht-pharmakologischen, alternativen Heilverfahren kann oft nicht die Mittel aufbringen, um große Experimente zu finanzieren. Das Problem sind weniger die explorative Studien selbst, sondern deren Darstellung in den Fachblättern und Weitervermittlung in den Medien. Letzteren fehlt es oft an Geduld, kleinere Wissenschaftsmeldungen adäquat aufzubereiten.

Und an den Universitäten und in den Forschungsabteilungen herrscht seit je her die Lust, lieber neue, aufregenden Ergebnisse zu produzieren als alte zu überpüfen oder gar Nullhypothesen zu bestätigen. Hier wären Anreize neu zu setzen. In der Psychologie ist das Problem am frühesten erkannt worden. Ansonsten gelten die schon in „Arzneimittel – der kontinuierliche Skandal“ ausgeführten Transparenzgebote. So sollten beispiels- und zentralerweise alle Studien im Vorwege registriert werden, um die nachträgliche Änderung von Endpunkten zu verhindern. Die Rohdaten müssen zu einem späteren Zeitpunkt für jedermann zugänglich sein, um Folgeanalysen durchführen zu können. Und ein guter Abschlusssatz fällt mir nicht ein.