Künstliche Intelligenz, Heft 3/2002

„Als Intelligenz würde ich das noch nicht bezeichnen“

Der Organisator der RoboCup German Open und Teamchef der kickenden Fraunhofer Robots, Ansgar Bredenfeld, spricht über die Funktionsweise autonomer Roboter, die Stärken und Schwächen seines Teams und die neuen Regeln beim RoboCup 2002.

Parallel zur Weltmeisterschaft der Fußballprofis in Japan und Korea findet in diesem Jahr eine Meisterschaft der kickenden Roboter statt. Der letzte Test der deutschen Teams unter Wettkampfbedingungen fand im April bei den RoboCup German Open statt. Der Organisator der RoboCup German Open und Teamchef der kickenden Fraunhofer Robots, Dr. Ansgar Bredenfeld, sprach mit der KI über die Funktionsweise autonomer Roboter, die Stärken und Schwächen seines Teams und die neuen Regeln beim RoboCup 2002.

Fußballmeisterschaften der Roboter sind kein Freizeitvergnügen für Studenten mehr. Deutlichstes Zeichen für die Relevanz der Veranstaltungen ist wohl, dass die Deutsche Forschungsgemeinschaft mit einem Schwerpunktprogramm die Wissenschaft vom künstlichen Kicken fördert. Unter dem Titel „Kooperierende Teams mobiler Roboter in dynamischen Umgebungen“ (DFG-Schwerpunkt 1125 „RoboCup“) stehen sechs Millionen Mark für die teilnehmenden Universitäten und Forschungsinstitute zur Verfügung.

KI: Die Roboter des AiS gelten als verhaltensbasierte Systeme. Was ist der Unterschied zum klassischen Ansatz in der Künstlichen Intelligenz?

Im Gegensatz zu einem klassischen Ansatz zur Bewegungskontrolle des Roboters, bei dem Pfade auf der Grundlage eines symbolischen Modells der Welt geplant werden, die dann in Steuerkommandos für die Roboterbewegungen umgesetzt werden, benutzen wir einen verhaltenbasierten Ansatz. Dieser Ansatz zeichnet sich dadurch aus, dass der Roboter direkt auf seinen sensorischen Input reagiert und dann eine geeignete Aktion auswählt. Eine durch eine Sensorinformation ausgelöste Aktion ändert die Lage des Roboters in der Welt, wodurch sich wieder die Sensorinformation ändert. Diese senso-motorische Rückkopplung schließt einen Regelkreis direkt über die Umwelt, deren Veränderung natürlich nicht exakt vorausberechnet werden kann. Schon gar nicht, wenn es sich um eine hochdynamische Umwelt handelt. Durch den Nicht-Determinismus der Umwelt kann es auch zu komplexen Überlagerung von Verhalten kommen, so dass „scheinbar“ ein Gesamtverhalten entsteht, dass der Programmierer so nicht von vornherein für den Roboter vorgesehen hat. Auch kann das Gesamtverhalten des Roboter durchaus bewirken, dass der Betrachter absichtliche Aktionen unterstellt, die so nicht vom Programmierer des Roboters vorgesehen waren. Dann spricht man dem Roboter leicht mehr zu, als in ihm tatsächlich einprogrammiert worden ist.

KI: Vor allem, aber nicht nur Kinder unterliegen diesem Animismus.

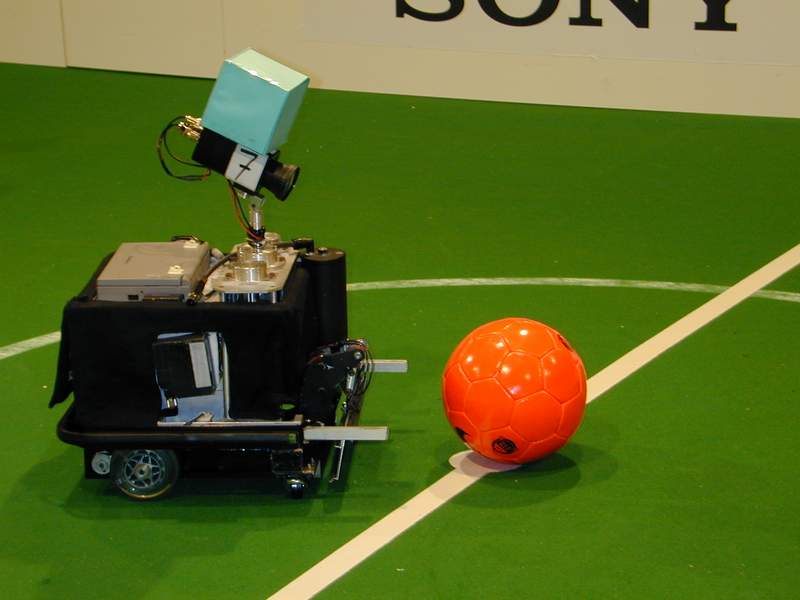

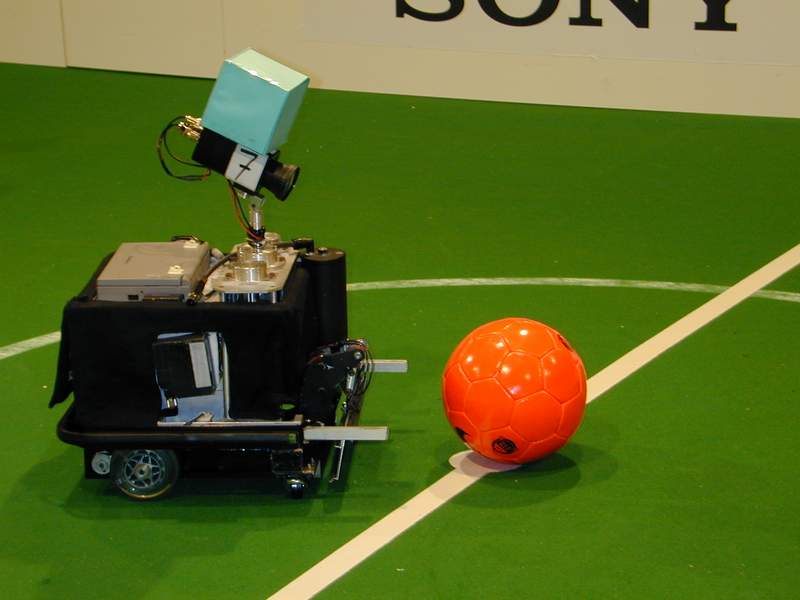

Ja. Wir haben bei den Spielen viele Kinder unter den Zuschauern, die enorm an den Robotern interessiert sind. Gerne versuchen sie den Robotern zu zeigen, wo der Ball ist. Unsere Robots sind zum Beispiel so konstruiert, dass sie ständig den Ball fixieren, und wenn sie ihn nicht sehen, dann kreist die Kamera so lange, bis sie in wieder gefunden haben. Wenn ein Ball an ihnen vorbeiläuft, dann folgt die Kamera dem Ball. Das führt bei Kindern offenbar dazu, den Roboter als etwas zumindest kommunikationsfähiges anzusehen.

KI: Sie würden ihre Roboter also nicht als intelligent bezeichnen?

Würde die visuelle Ballverfolgung nur auf dem Bildschirm stattfinden, würde kein Hahn danach krähen. Aber weil das Programm in einem Roboter verkörpert ist, kann diesem Programm leicht mehr unterstellt werden als softwaretechnisch zu rechtfertigen ist. Dabei führen unsere Roboter lediglich in Abhängigkeit des Sensorinputs zielgerichtete Aktionen in koordinierter Weise aus, aber als Intelligenz würde ich das noch nicht bezeichnen.

KI: Warum nutzen Sie zunächst eine PC-Simulation für die Aktionen des Roboters?

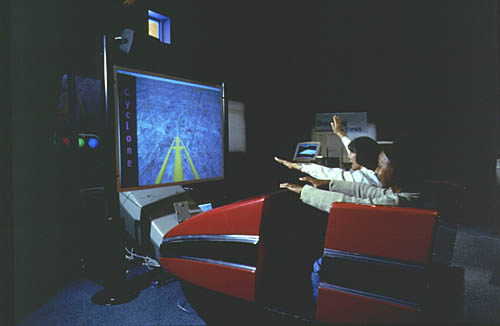

Experimente mit realen Robotern sind sehr zeitaufwendig. Wir müssen ins Robotik-Labor gehen, die Roboter vorbereiten und dann schließlich die Experimente durchführen. Die Simulation dagegen kann sehr einfach im Büro am PC durchgeführt werden. Besonders wichtig ist die Simulation dann, wenn das Roboterprogramm lernen soll. Hierfür sind sehr viele Experimente notwendig, die in der Simulation automatisch, z. B. über Nacht, durchgeführt werden können. Wichtig ist dabei natürlich eine möglichst große Realitätsnähe des Simulators, damit die Simulationsergebnisse auch aussagefähig für die Realität sind. Wir haben schon sehr früh angefangen, einen Simulator zu bauen. Mit ihm entwickeln wir die Programme für die späteren Bewegungsabfolgen auf dem Spielfeld. Wenn die Roboter in der Simulation sinnvoll agieren, dann überspielen wir das Programm auf den echten Roboter und gehen aufs Feld. Dort optimieren wir dann die Parameter.

KI: O.k. der Roboter steht auf dem Spielfeld. Wie werden nun die Informationen der verschiedenen Sensoren koordiniert?

Ein einfaches Beispiel: Wenn ein Hindernis von den Infrarot-Sensoren erkannt wird, löst dies in der Regel eine Ausweichbewegung des Roboters aus. Wenn allerdings beim Roboterfußball als Hindernis der rote Ball erkannt wird, muss die Information der Infrarot-Sensoren anders interpretiert werden. An dieser Stelle wird die Information von zwei Sensoren – der Kamera und die Infrarotsensoren – zusammen betrachtet und durch die Kombination ergibt sich dann gewissermaßen eine höherwertige Information, die zu einer anderen Bewegungsentscheidung führt.

KI: Welche Sensoren nutzen sie noch, um die Roboter auf dem Spielfeld autonom agieren zu lassen?

An den Rädern zählen wir, wie oft sie sich drehen. Zudem haben wir einen Winkelgeschwindigkeitsmesser mit dem wir die Orientierung auf dem Spielfeld berechnet. Dann haben die Roboter noch Bumper-Sensoren, so dass sie merken, wenn sie irgendwo anstoßen. Im Spiel muss man nämlich zeigen, dass man sich nach einer Kollision entfernt, sonst läuft man Gefahr für ein Foul angezeigt zu werden. Zusätzlich haben unsere Roboter Infrarot-Abstandssensoren direkt nach vorne und nach vorne seitlich im 45 Grad Winkel ausgerichtet sind. Das sind unsere Sensoren zur Hindernisvermeidung, insgesamt also eine minimalere Sensorausstattung im Vergleich beispielsweise zum amtierenden Weltmeister-Team aus Freiburg, das einen Laserscanner benutzt, mit dem der Raum vor dem Roboter sehr fein abgetastet wird.

KI: Der Spieler sieht den Ball und der Ball muss ins Tor. Wie geht er vor?

Erst einmal muss er wissen, wo er ungefähr steht. Im Prinzip versucht er dann unter Hindernisvermeidung den Ball ins Tor zu bringen. Je nachdem wo er steht, wo die Gegner stehen, wo das gegnerische Tor steht und wo der Ball ist, ergeben sich da unterschiedlichste Spielsituationen. Diese unterschiedlichen Situationen werden erkannt und aktivieren gewisse Grundverhalten. Wenn der Roboter hinter dem Ball steht, dann muss er beispielsweise erst vor den Ball fahren, um ein Tor zu schießen. Wenn er den Ball vor dem eigenen Tor sieht, dann springt ein Verhalten an, welches den Schuss eines Eigentores vermeidet. Oder: Wenn das gegnerische Tor und der Ball in einer Linie sind, dann gibt es ein Verhalten, welches instruiert „Beschleunigen, dann schießen“. Es existieren also viele kleine Elementarverhalten, welche eine bestimmten Aufgabe erfüllen sollen und den Motor entsprechen ansteuern. Die kann man isoliert betrachten, programmieren und testen. Sie sind gewissermaßen unsere Bausteine, unser Vokabular, um komplexere Verhalten zu komponieren.

KI: Wie lassen sich die unterschiedlichen Elementarverhalten kombinieren?

Eine rein sequentielle Ausführung der Grundverhalten würde zu roboterhaften, sehr abgehackten Bewegungen führen. Das liegt am abrupten Umschalten zwischen verschiedenen Aktionen. Durch Sensorrauschen kann es hierbei zu Oszillationen zwischen Verhalten kommen, wenn der Roboter sich zum Beispiel nicht zwischen Hindernisvermeidung und Torschuss entscheiden kann. Das ist ein Nachteil einer rein sequentiellen Ausführungen und Umschaltung von Elementarverhalten. Wir gehen deshalb anders vor: Den Elementarverhalten wird eine graduelle Aktivierung zugeordnet, das heißt, wenn die Elementarverhalten parallel laufen, dann ist eines beispielsweise nur zur Hälfte aktiviert, eines ist ganz ausgeschaltet, eines ist vollständig aktiviert. Jedes der Verhalten steuert auf diese Weise einen Teil zum Gesamtverhalten bei.

KI: Und wie viele Elementarverhalten agieren in ihren Robotern?

Die Zahl der Elementarverhalten liegt derzeit deutlich unter 100. Die Kombination von sehr vielen Verhalten stellt hierbei generell ein Problem dar, da unterschiedliche Elementarverhalten zu unterschiedlichen Anteilen miteinander kombiniert werden. Langfristig wünschen wir uns, dass wir mindestens einen Teil der hierfür notwendigen Parameter mit automatisierten Lernverfahren ermitteln können.

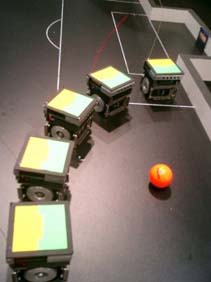

KI: Ihre Roboter sind über Funk-LAN miteinander verbunden. Was tauschen die Spieler untereinander aus?

Die relative Lage des Roboters zum Ball, also Abstand und Winkel, wird transparent im Team verteilt. Wenn gestürmt wird, dann kann so der Roboter zum Ball fahren, der am nächsten dran ist. Das macht man im richtigen Fußball ja auch nicht komplett anders. Wir versuchen aber auch, den Roboter so zu programmieren, dass er alleine in der Welt zurecht kommt. Wenn er mit den anderen kommunizieren kann, ist das allerdings ein Vorteil, das Gesamtsystem bricht aber nicht zusammen, wenn die Kommunikation zwischen den Robotern ausfällt, was bei den Turnieren keine Seltenheit ist.

KI: Können aus der Abwehr Pässe nach vorne geschlagen werden?

Das gezielte Passen ist bisher nur selten mal einem Team gelungen. Da gibt es bisher nur Ansätze. Was wir aber schon sehen ist die gezielte Nutzung der Bande für Torschüsse.

KI: Gibt es Taktiken? Stellen Sie Ihre Roboter auf den Gegner ein?

Wir entscheiden beispielsweise je nach Lage, ob wir mit einem oder zwei Stürmern spielen. Diese Taktik ist relativ einfach zu implementieren und zeigt im Spiel schon unerwartet gute Effekte. Was das Positionsspiel angeht, verfahren wir so, dass ein Roboter, wenn er länger den Ball nicht sieht, in die Abwehr oder an eine vorbestimmte Spielfeldposition zurückfährt.

KI: Spielt Antizipation in den Aktionen eine Rolle?

Da haben wir vor zwei Jahren ein interessantes Experiment durchgeführt. Im Simulator haben wir ein Neuronales Netz auf die Information trainiert, ob der simulierte Roboter in nächster Zeit den Ball verlieren wird. Wenn er das merkt, dann kann er eine Aktion ausführen, in unserem Test zum Beispiel den Ball wegschießen. Bei der Weltmeisterschaft in Melbourne haben wir das auch am echten Roboter ausprobiert und es hat sich schon gezeigt, dass er in aussichtlosen Situationen den Ball tatsächlich geschossen hat.

KI: Wie weit lässt sich ihr Team von dem menschlichen Fußballspiel stimulieren? Welche Übertragungsmöglichkeiten gibt es?

Das man aus dem richtigen Fußballspiel Elemente herausgreift, dass kommt bei uns in der Liga eher noch nicht vor. In der Simulationsliga, wo komplette simulierte Fußballmannschaften gegeneinander antreten, da schaut man schon auf Aufstellungen und bedient sich taktischen Wissens aus der Fußballszene.

KI: Können Ihre Roboter lernen?

Ein Lernsystem haben wir zur Zeit noch nicht an Bord, wir arbeiten aber auf der Ebene des Motor-Controllers daran. Je nach Situation reagiert der Roboter auf Fahrkommandos sehr unterschiedlich. Die Gewichtsverteilung auf dem Roboter, die daraus resultierenden Trägheitsmomente, die Reibung der Räder, die Charakteristik der Motoren in verschiedenen Lastsituationen sind Dinge, die man nur schwer kalkulieren kann. Der Roboter soll daher lernen – je nach aktueller Fahrtsituation – durch Über- oder Gegensteuern die gewünschte Geschwindigkeit und Rotation bestmöglichst zu erreichen.

KI: Woran arbeiten sie momentan? Was sind die kommenden Aufgaben?

Beim jetzigen und den zukünftigen RoboCup-Wettbewerben in unserer Liga wird es keine Bande mehr als Spielfeldbegrenzung geben. Darum müssen wir die Bildverarbeitung gründlich überarbeiten. Die Eckfahnen werden in Zukunft farbig markiert sein, daran werden sich die Roboter neben den farbigen Toren orientieren müssen.

KI: Mit vielen Leuten arbeiten sie am Projekt RoboCup?

Der RoboCup ist für uns eine Demonstrationsanwendung, an der wir unsere Forschungsergebnisse auf dem Gebiet der autonomen mobilen Roboter erproben können. Beispielsweise ist unsere Entwicklungsumgebung nicht spezifisch für den RoboCup entworfen worden, sondern lässt sich auch für andere Robotersysteme einsetzen, konkret in einem Projekt, in dem es um den Einsatz von mobilen Robotern in der Produktion geht. Daran arbeiten zur Zeit drei Leute. Im Schnitt arbeiten dann drei bis vier Leute an den Robotern, wobei die immer auch in anderen Bereichen tätig sind.

KI: Mittlerweile genießt der RoboCup eine steigende öffentliche Aufmerksamkeit. Führt das zu mehr Konkurrenzdenken unter den Teams?

Generell ist die Atmosphäre beim RoboCup kooperativ geprägt und stellt den wissenschaftlichen Austausch in den Vordergrund. Parallel zum RoboCup findet so immer ein Symposium statt, auf dem die neuesten Erkenntnisse der Teams vorgestellt werden. Man lässt die anderen Mannschaften durchaus in die eigenen Karten schauen. Unter den Teams bestehen zum Teil sogar gute Kontakte und man hilft sich bei technischen Problemen.

KI: Bleibt in Hinsicht auf den RoboCup nur noch die Frage, wer dieses Mal Weltmeister wird? Wieder das Freiburger Team?

Das ist tatsächlich eine interessante Frage. Da die Bande nicht mehr vorhanden sein wird, fällt ein wichtiger Vorteil für den amtierenden Weltmeister aus Freiburg weg. Diese orientierten sich bislang mithilfe ihrer Laserscanner an den Banden und konnten so ein recht komplettes symbolisches Weltmodell in ihren Robotern mitführen auf dem Spielzüge geplant werden können. Für sie stellt sich die Aufgabe, nur anhand der Tore und Eckfahnen rauszufinden, wo sie genau sind. Bandenschüsse wird es zudem ebenfalls nicht mehr geben. Die Karten werden also neu gemischt und ich halte daher das Turnier für offen.

KI: Um etwas theoretischer zu werden: Die KI-These des Embodiment, der körpergebundenen Intelligenz, hat sich von der Symbolverarbeitung verabschiedet. Wie arbeiten symbolische Planungsprozesse und nicht-symbolischen Reaktionsmechanismen zusammen? Wie passen Verkörperung und Symbolverarbeitung zusammen?

Wir haben momentan zwar noch keine Planungskomponenten auf den Robotern, es gibt aber vielfältige Überlegungen dazu, wie man unsere reaktive verhaltensbasierte Architektur mit deliberativen Planungsprozessen zusammenbringen kann. Das Auffinden und Definieren geeigneter Schnittstellen zwischen diesen beiden Aspekten ist derzeit ein interessantes Forschungsthema.

KI: Ist das von AiS entwickelte „Dual Dynamics“ eine Lösung? Was muss man sich darunter vorstellen?

Dual Dynamics beschreibt eine Architektur von Verhaltensmodulen und deren Zusammenwirken bei der Steuerung eines Roboters. Ein Verhaltensmodul besteht aus zwei Teilen: einem Teil, der berechnet, inwieweit das Verhaltensmodul in der augenblicklichen Situation aktiviert wird und Einfluss auf das Gesamtverhalten des Roboters nehmen soll, und einem anderen Teil, der berechnet, welche Kommandos an die Motoren geschickt werden sollen. Diese Trennung und die zugrundeliegende Mathematik, die aus der Theorie dynamischer Systeme kommt, haben uns bei der Realisierung unserer Verhaltensprogramme sehr geholfen. Für die Kopplung mit einer Planungskomponente versuchen wir Aktivierungsmuster auszunutzen. Ein Aktivierungsmuster ist immer auch eine Abstraktion einer Sequenz von Situationen, die der Roboter durchläuft. Wenn ich die Sensorinformation komplett auswerten wollte, um darauf eine Planung herzuleiten, dann gerate ich in einen riesigen Parameterraum. Aber die aus der Sensorinformation abgeleitete Aktivierung von bestimmen Elementarverhalten ist ein Abstraktionsschritt, der mir eine Repräsentation von Situationen liefern kann, in denen sich der Roboter gerade befindet. Hierbei wird nicht versucht die Welt im Roboter symbolisch „nachzubauen“, sondern es existiert eine gewisse Roboterbezogene Innensicht. So ist der Roboter – wenn man es denn so formulieren will – in einer gewissen „Stimmung“ ein Tor zu schießen und dabei einem Hindernis auszuweichen. Was das für ein Hindernis ist und wo ich mich auf dem Spielfeld befinde, bleibt dabei relativ egal.

KI: Spielt die Natur eine Vorbildrolle für ihre Arbeit?

Sicher, gerade bei der Verhaltenssteuerung und der Bildverarbeitung. Wir werden sicher nicht ein Bild nehmen und eine komplette Symbolextraktion versuchen, so viel Rechenzeit haben wir auf dem Roboter nicht verfügbar. In der Bildverarbeitung ist es aussichtsreicher nur auf die Merkmale im Bild zu achten, die für die aktuell aktiven Verhalten von Bedeutung sind. In einem Forschungsprojekt des DFG-Schwerpunktprogrammes „RoboCup“ untersuchen wir derzeit biologisch inspirierte Bildverarbeitung und überprüfen unter anderem, inwieweit sich analoge Bildverarbeitungschips in Robotern einsetzen lassen. Auch bei diesen neuartigen Sensoren stand übrigens die Natur Pate.

KI: Wenn Sie schon ihrem Roboter keine Intelligenz zuschreiben wollen, dann ist ein Schachprogramm für Sie erst recht unintelligent?

Das Schachspiel besitzt klar definierte Zustände und Operationen in einer statischen und vollständig bekannten Umgebung. Darauf können existierende Verfahren der Computerprogrammierung relativ einfach angewandt werden. Ganz anders ist dagegen unsere Umgebung im Alltag: wir handeln zum Teil in zeitkritischen Situationen auf grund von unsicheren Sinneseindrücken. Diese „Alltags-Intelligenz“ ist symbolbasierten Computersystemen nur schwer beizubringen und das Schachspiel hat damit natürlich gar nichts zu tun. Anders verhält es sich hier mit dem RoboCup. Autonome technische Systeme scheitern zwar momentan noch in komplexen dynamischen Umgebungen, aber der RoboCup ist sicher der richtige Weg um schrittweise den Anteil natürlicher Umwelt und die Dynamik zu erhöhen. Wenn in den nächsten Turnieren die Bande fällt, dann wird es schwieriger für die Roboter, aber das ist ja auch Sinn der Übung: Das Szenario soll schrittweise immer realistischer werden. Aber bis zum Roboterteam, das gegen den amtierenden Weltmeister gewinnen kann, oder zum Roboter, der uns in der Fußgängerzone unsere Einkäufe hinterher trägt, ist es sicher noch ein weiter und steiniger Weg.

KI: Was ist denn für Sie das Kernkriterium für Intelligenz?

Intelligenz wäre für mich gegeben, wenn der Roboter von sich aus Voraussagen über das Verhalten seiner Mitspieler und Gegner macht. Das wäre eine beeindruckende Leistung.

Das Interview führte Jörg Auf dem Hövel. Vom ihm erscheint im Herbst 2002 ein Buch unter dem Titel Abenteuer Künstliche Intelligenz. Auf der Suche nach dem Geist in der Maschine im discorsi Verlag.

Eine der Homepages, die ganz oben auf der Liste der VDC steht, ist die der Allianz Freies Vietnam. Die Organisation von Exil-Vietnamesen setzt sich für die Demokratisierung des Heimatlandes ein und bemüht sich unter anderem den Informationsfluss aufrecht zu erhalten. Politische Nachrichten aus Vietnam werden von uns gesammelt und wieder ins Land zurück geschickt, erklärt H. Tran, außenpolitischer Sprecher der Organisation in Deutschland. Das Internet biete hierfür ideale Bedingungen und mit dem anwachsenden Datenaufkommen würde die Kontrolle der Inhalte immer schwerer.

Eine der Homepages, die ganz oben auf der Liste der VDC steht, ist die der Allianz Freies Vietnam. Die Organisation von Exil-Vietnamesen setzt sich für die Demokratisierung des Heimatlandes ein und bemüht sich unter anderem den Informationsfluss aufrecht zu erhalten. Politische Nachrichten aus Vietnam werden von uns gesammelt und wieder ins Land zurück geschickt, erklärt H. Tran, außenpolitischer Sprecher der Organisation in Deutschland. Das Internet biete hierfür ideale Bedingungen und mit dem anwachsenden Datenaufkommen würde die Kontrolle der Inhalte immer schwerer.

Wer am Nachmittag des Jahrestags des Erscheinens von Orwells „1984“, am malerischen Wiener Donaukanal flanierte, konnte vor dem Szenelokal Flex die Gruppe temperamentvoller Diskutanden kaum überhören. Berge von Computerausdrucken, Briefen und Notizen auf dem Kaffeetisch vor sich hektisch durchwühlend, wurden neugierige Frager ungewohnt barsch abgewiesen. Doch Wiener Charme milderte die Reaktion: „Normalerweise sind wir viel netter, aber jetzt sind wir im Stress wegen der Preisverleihung heute abend… komm doch heute abend um neun!“ Von einer Jurorin so freundlich eingeladen, wollte man die Auswahl der AwardGekrönten dann nicht weiter stören. Zumal das Flex, das die phonstärkste Anlage Österreichs sein eigen nennt, zur BigBrother Party mit DJ Hell „Eintritt frei“ versprach. Und so ließ man die Jury in Ruhe ihres Amtes walten, die unter anderem aus Vertretern der „Österreichischen Gesellschaft für Datenschutz“ und dem „Verein zur Wiederherstellung der Bürgerrechte im Informationszeitalter“ bestand.

Wer am Nachmittag des Jahrestags des Erscheinens von Orwells „1984“, am malerischen Wiener Donaukanal flanierte, konnte vor dem Szenelokal Flex die Gruppe temperamentvoller Diskutanden kaum überhören. Berge von Computerausdrucken, Briefen und Notizen auf dem Kaffeetisch vor sich hektisch durchwühlend, wurden neugierige Frager ungewohnt barsch abgewiesen. Doch Wiener Charme milderte die Reaktion: „Normalerweise sind wir viel netter, aber jetzt sind wir im Stress wegen der Preisverleihung heute abend… komm doch heute abend um neun!“ Von einer Jurorin so freundlich eingeladen, wollte man die Auswahl der AwardGekrönten dann nicht weiter stören. Zumal das Flex, das die phonstärkste Anlage Österreichs sein eigen nennt, zur BigBrother Party mit DJ Hell „Eintritt frei“ versprach. Und so ließ man die Jury in Ruhe ihres Amtes walten, die unter anderem aus Vertretern der „Österreichischen Gesellschaft für Datenschutz“ und dem „Verein zur Wiederherstellung der Bürgerrechte im Informationszeitalter“ bestand.